Anna Hoffmann Consulting

AI-Literacy: mehr als Grundlagenwissen zu KI

AI Literacy ist die Fähigkeit, KI-Anwendungen zu verstehen, zu nutzen, zu überwachen und kritisch zu reflektieren.

Aus dem "Hinweispapier KI-Kompetenzen nach Artikel 4 KI-Verordnung" der Bundesnetzagentur:

KI-Symbolbild via Adobe Firefly

"KI-Kompetenz ist Voraussetzung, um fundierte Entscheidungen zu treffen, Risiken zu minimieren und gesetzliche Vorgaben einzuhalten. Gleichzeitig ermöglicht sie, dass das Potenzial von KI bestmöglich genutzt wird...

Der Aufbau von KI-Kompetenz ist ein kontinuierlicher Prozess."

"Die KI-Verordnung legt nicht fest, wie die KI-Kompetenz konkret aufzubauen ist. Es werden keine standardisierten Trainingsmaßnahmen vorgegeben.

KI nutzende Organisationen können selbst entscheiden, wie sie nach bestem Wissen und Gewissen die KI-Kompetenz sicherstellen."

„Die Fähigkeit, künstliche Intelligenz zu verstehen, kritisch zu hinterfragen und verantwortungsvoll einzusetzen, ist heutzutage essenziell .“

Bundesnetzagentur

Ein Einblick in die EU AI Act Compliance-Erfordernisse für Artikel 4 auf der Basis der Veröffentlichungen der Bundesnetzagentur

KI-Symbolbild via Adobe Firefly

KI-Symbolbild via Adobe Firefly

KI-Symbolbild via Adobe Firefly

KI-Symbolbild via Adobe Firefly

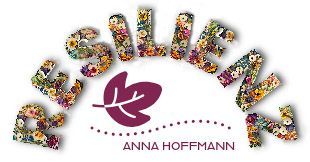

Halluzinationen und Falschaussagen nehmen beim Einsatz der "Reasoning"-Systeme zu:

"Mehr als zwei Jahre lang haben Unternehmen wie OpenAI und Google ihre KI-Systeme ständig verbessert und die Häufigkeit dieser Fehler verringert.

Doch mit dem Einsatz neuer "reasoning" Systeme nehmen die Fehler zu. Die neuesten OpenAI-Systeme halluzinieren laut eigenen Tests häufiger als das vorherige System des Unternehmens.

Tests von unabhängigen Unternehmen und Forschern zeigen, dass die Halluzinationsraten auch bei Denkmodellen von Unternehmen wie Google und DeepSeek steigen."

Reasoning Modelle versuchen, ein Problem Schritt für Schritt anzugehen. Dabei laufen sie Gefahr, bei jedem Schritt zu halluzinieren. Die Fehler können sich häufen, je mehr Iterationen die Resaoning-Systeme durchlaufen.

Quellen: Studie von OpenAI und Bericht in der New York Times

KI-Symbolbild via Adobe Firefly

KI-Symbolbild via Adobe Firefly

Vortrag auf der Jahrestagung der Gesellschaft für Informatik "Informatikfestival 25"

"Menschzentrierte KI"

Zwischen Versprechen und Realität - die KI-Praxis von Big Tech

Tagesworkshop für die KI-Allianz Baden-Württemberg zum EU AI Act, Schwerpunkt Artikel 4 , am 28.11.2025 im Carl-Friedrich-von-Weizäcker-Zentrum an der Uni Tübingen

KI-Symbolbild via Adobe Firefly

Aus dem Inhalt:

- EU AI Act Basics: Worum geht es?

- Interaktiver Input zu Grundlagen sowie Chancen und Risiken von Generativen KI-Modellen:

a) Wissensgraphen und Machine Learning – Erfolgreiche KI-Modelle seit 15 Jahren und Grundlage für KI-Systeme wie Microsoft Copilot

b) LLMs (wie ChatGPT), die Transformerarchitektur (das T in GPT) und LRMs (KI-Agenten)

c) Chancen und Risiken von LLMs, LRMs (KI-Agenten) und Bildgebender KI (Deepfakes)

d) Die Empfehlungen des Bundesamts für Sicherheit in der Informationstechnik zum Einsatz von Generativer KI

- Deep Dive zu Art. 4: Aufbau von KI-Kompetenzen in KMUs

- Die Umsetzung des EU AI Acts (Artikel 4) im eigenen Unternehmen starten

- Die organisationale Zukunftsfähigkeit durch den EU AI Act erhöhen

KI-Symbolbild via Adobe Firefly

Tagesseminar in Präsenz in

Tübingen, Berlin oder Hamburg:

EU AI Act für Beratende Berufe

Ein praxisorientiertes Seminar, bei dem die Vermittlung von eigenen Erfahrungen in Methodiken zu KI-Kompetenz im Mittelpunkt steht

Kleingruppe mit maximal 5 TN für einen intensiven, Hands-On Wissenstransfer mit vielen Erfahrungen, Übungen und Spaß!

Nächster Termin in Tübingen: 18. Juli (Freitag)

Nächster Termin in Berlin: 25. Juli (Freitag)

Nächster Termin in Hamburg: 7. August (Donnerstag)

Abschluss: Teilnahmebescheinigung der Universität Tübingen (CFvWZ)

- EU AI Act Basics: Worum geht es? Was sind die wichtigsten Anforderungen? Was sollte ich wissen? (Bundesnetzagentur/KI-Service Desk)

- Chancen und Risiken von Generativen KI Modellen: Input nach den Standards des Bundesamts für Sicherheit in der Informationstechnik

- Wertebasis "Menschzentrierte KI" des EU AI Acts - Was ist das überhaupt?

- KI-Canvas: Was ich muss ich für die Integration von KI-Modellen beachten?

- Übung "Reinforcement Learning" - die KI-Grundlage für die Robotik der Zukunft

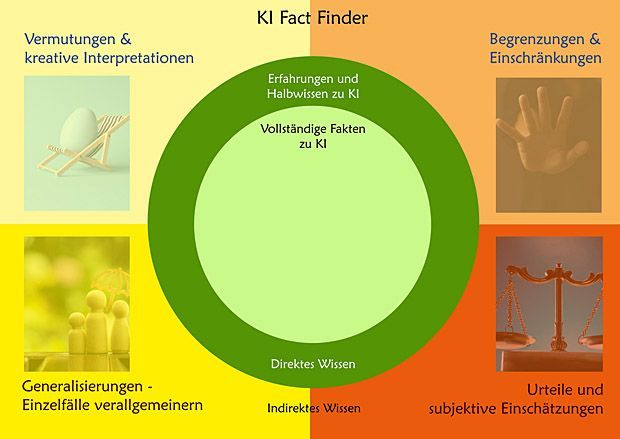

- KI-Fact-Finder: Workshop für KI-Kompetenzerfassung von Mitarbeitenden

Die partizipativen Methodik "KI Fact Finder", hilft dabei, eine der Anforderungen des Artikel 4 zu erfüllen: Ein gemeinsames Verständnis von KI im Unternehmen zu entwickeln.

- Workshop “Ethik-Kompass” gemäß Mittelstand- Digital Zentrum "Zukunftskultur":

Ethische Kenntnisse zu KI werden vom EU AI Act erfordert und sind häufig eine Schwachstelle in der KI-Strategie von Unternehmen. Sie erleben die Durchführung eines Ethik-Workshops.

KI-Symbolbild via Adobe Firefly

Mit dem praktischen Basisseminar soll ein grundlegendes Verständnis von KI Anforderungen und dem EU-AI Act sichergestellt werden. Praktische Methoden und Workshops ergänzen den Wissenstransfer in den eigenen Arbeitsalltag.

Leistungsnachweis: Aktive Teilnahme an den Interaktionen und Ausfüllen der "Selber denken“ Templates

Ablauf des Seminartages:

9.00 bis 13.00 Uhr: Interaktive Lehre inkl. Workshop "Fact Finder"

13.00 bis 14.00 Uhr Pause und ggf. Nachtrag in die „Selber denken“ Templates

14.00 bis 17.00 Uhr: Praxis "Reinforcement Learning" & Workshop "Ethik Kompass"

Kosten: 590,- € netto pro Teilnehmende Person

Abschluss: Teilnahmebescheinigung der Universität Tübingen (CFvWZ)

Nächster Termin in Tübingen: 18. Juli (Freitag)

Nächster Termin in Berlin: 25. Juli (Freitag)

Nächster Termin in Hamburg: 7. August (Donnerstag)

Die Methodik "KI Fact Finder" für die Umsetzung des EU AI Acts in KMUs

Eine kurze Vorstellung der partizipativen Methodik "KI Fact Finder", die dabei hilft,

eine der Anforderungen des Artikel 4 zu erfüllen: Ein gemeinsames Verständnis von KI im Unternehmen zu entwickeln.

Dieser "Common Ground zu KI" in der Organisation tragt maßgeblich dazu bei, verantwortungsvoll mit KI umzugehen und

typische Risiken im Umgang mit KI minimieren.

Einen Common Grund zu KI-Frage zu entwickeln ist insbesondere bei Einsatz von Generativer KI (Copilot, ChatGPT, Zoom AI Companion) notwendig, weil der EU AI Act erwartet, dass alle Mitarbeitenden, die KI nutzen, einen kompetenten und rechtssicheren KI-Background haben (= Kenntnis über den Aufbau von KI-Systemen, Ursachen für Fehler, ethische Kenntnisse zu menschzentrierter KI etc).

Verantwortlich handeln:

KI-Seminare und Learning Journeys Online für den KI-Kompetenzerwerb

Aktuelle Entwicklungen in der Künstlichen Intelligenz einordnen und Zukunft gestalten können: Meine Angebote in Zusammenarbeit mit dem Carl-Friedrich-von-Weizäcker-Zentrum der Universität Tübingen. Inhouse, online oder in Präsenz in Tübingen.

KI ist durch die Vielfältigkeit der Systeme kein einfaches Thema. Wir geben Ihnen in unserern Learningjourneys und Kompaktformat einen Überblick, der Sie in Ihrer Entscheidungskompetenz stärkt und strategische Entscheidungen für Ihre Organisation einfacher macht: So können Sie aktuelle Entwicklungen in der Künstlichen Intelligenz einordnen und die Zukunft gestalten.

Um KI auf verantwortungsvoll nutzen zu können, werden Fähigkeiten benötigt, die über die Nutzung (Prompting etc.) und das Erfahrungswissen im Umgang mit verschiedenen KI-Systemen hinausgehen. Dazu gehört auch die Kompetenz zur Einordnung und Analyse der grundlegenden Datenverarbeitungsprozesse in den KI-Grundtechnologien, um informierte, optimierte und kontextabhängige Entscheidungsprozesse zu garantieren.

Das CFvWZ bietet vielfältige, interaktive und gut strukturierte AI Literacy Seminare für die Anforderungen des EU AI Acts. Wir machen die Erfüllung des Artikel 4 einfach und interessant!

KI-Symbolbild via Adobe Firefly

Die von mir konzipierten AI Aktivitäten und Angebote des Carl-Friedrich-von-Weizäcker-Zentrums sind auf der "The AI LÄND Map" gelistet, einer Initiative des Staatsministerium Baden-Württemberg.

Interaktives Onlineseminar:

Der "KI-Freischwimmer"

Online-Tagesseminar in Zoom mit interaktiven Einheiten zur kritischen Analyse durch die Teilnehmenden:

12 Lektionen gemäß der "EU-Literacy Definition" mit vertieftem, individuellem Praxistransfer

Ein Angebot in Kooperation mit dem CFvWZ an der Universität Tübingen:

- Verantwortungsvoller Umgang mit KI: Was bedeutet das konkret?

- Erklärbarkeit: Wie kommen KI-Systeme zu Ihren Ergebnissen? Welche KI-Arten gibt es, und was macht sie aus? Wie funktioniert Chat GPT?

- Genauigkeit: Warum nehmen die Fehler bei "Reasoning"- KI-Systemen zu? Wie zuverlässig arbeiten KI-Systeme?

- Fairness: Sind KI-Entscheidungen neutraler als menschliche Entscheidungen? Wo verhält sich die KI entgegen unseren Erwartungen?

- Recht & Ethik: Welche Auswirkungen hat der Einsatz von KI auf andere? Kenne ich alle Auswirkungen? Welche "unethischen" Probleme sind bekannt?

- Nachhaltigkeit: Nicht nur eine Frage der Energie! Wo macht KI Sinn und wo nicht?

- Governance: "Employee sentiment analysis" - Was ist das und welche Auswirkungen kann das haben?

- Risiken in der Nutzung von GenAI: Halluzinationen & Co.

- Eigene KI-Risiken bewerten und mindern: Die Adaptive Kontextanalyse

- Menschliche Intelligenz vs. künstliche Intelligenz: Wo stehen wir?

- Unerlaubte Nutzung von KI am Arbeitsplatz: Warum passiert das und wie damit umgehen?

- Grenzen der KI: Was kann KI nicht?

- Automatisierung von Entscheidungen: Was bedeutet das für Verantwortung in beruflichen Kontexten?

- Abschluss-Praxistransfer in den eigenen beruflichen Alltag

KI-Symbolbild via Adobe Firefly

KI-Symbolbild via Adobe Firefly

Generell soll für die KI-Kompetenz der Mitarbeitenden ein grundlegendes, allgemeines Verständnis von KI sichergestellt werden: Genau das wollen wir mit dem "KI-Freischwimmer" bieten: Eine Basisschulung für ein allgemeines Grundverständnis von Künstlicher Intelligenz und dem verantwortungsvollen Umgang mit KI.

Abschluss: Teilnahmebescheinigung der Universität Tübingen (CFvWZ)

Leistungsnachweis: Aktive Teilnahme an den Interaktionen und Ausfüllen der "Selber denken“ Templates

Ablauf des Seminartages:

9.00 bis 13.00 Uhr: 10 Lektionen live inkl. Interaktionen zum kritischen „Selber denken“

13.00 bis 14.00 Uhr Pause und ggf. Nachtrag in die „Selber denken“ Templates

14.00 bis 16.00 Uhr: Begleitete Videolektionen von Prof. Rainhard Kahle + Livecoaching zum individuellen Transfer in den eigenen beruflichen Alltag

Kosten: 2400,- € netto Paketpreis für Organisationen (bis zu 16 TN)

Was bedeutet KI-Kompetenz im Sinne des EU-AI-Acts?

„Die Fähigkeiten, die Kenntnisse und das Verständnis,

die es Anbietern, Betreibern (= Nutzenden) und Betroffenen

unter Berücksichtigung ihrer jeweiligen Rechte und Pflichten

im Rahmen dieser Verkehrsordnung ermöglichen

KI-Systeme sachkundig einzusetzen sowie sich der

Chancen und Risiken von KI und

möglicher Schäden, die sie verursachen kann, bewusst zu werden".

EU AI Act, Artikel 3, Nr.56

Wir fördern dieses Bewusstsein, indem wir keine Prüfung abnehmen, sondern zur bewussten Reflexion anregen.

Wir wollen keine schnellen Antworten, sondern erwarten eigenständiges, kritisches Denken. Darauf gibt es keine Noten:

Selber denken reicht!

Neu: Das "KI-Seepferdchen"

Ein modularer Online KI-Basiskurs für die Erfüllung der Bildungspflichten für Mitarbeitenden nach dem EU AI Act

Ein Angebot in Kooperation mit dem CFvWZ an der Universität Tübingen:

KI-Symbolbild via Adobe Firefly

Durch den modularen, hybriden Aufbau des Seminars kann die Weiterbildung optimal in den Arbeitsalltag integriert werden. Es entstehen nur geringe Produktivitätsverluste.

Das Seminar findet remote statt, ein Großteil der Inhalte kann selbstgesteuert zu einem gewählten Zeitpunkt gelernt und nach Belieben wiederholt und vertieft werden. Die Liveanteile für Fragen und Reflektionen finden in der Gruppe statt, die Termine für die einzelnen Liveanteile können vom Unternehmen mit den Dozenten individuell abgestimmt werden.

So bleibt die Arbeitskraft der Belegschaft trotz der Weiterbildung erhalten. Nur für die Liveanteile der Weiterbildung sollten alle TN gemeinsam vor den Bildschirm kommen. Durch das Instrument des Lerntagebuchs werden die inneren Reflexionen und Kompetenzgewinne während der Weiterbildung im Sinne des semantischen Tiefenlernens zunächst aktiviert und anschließend nachhaltig verankert.

Kosten: 2400,- € netto für bis zu 30 TN

(bei 30 TN nur 80,- € Kosten pro TN)

Das Dozententeam für das KI-Seepferdchen:

Prof. Reinhard Kahle, Leiter des CFvWZ der Universität Tübingen, Mathematiker, Informatiker und Ethischer Philosoph

Prof. Klaus Mainzer, Präsident der Europäischen Akademie der Wissenschaften und Künste

Anna Hoffmann, KI Dozentin,

u.a. Universität Tübingen, Universität Potsdam, HPI und HNE Eberswalde

Speakerin auf dem Informatikfestival 25 (Jahrestagung der Gesellschaft für Informatik), Universität Potsdam, Campus Griebnitzsee. Mittwoch, 17.09.2025

Talk: "Zwischen Versprechen und Realität - die KI-Praxis von Big Tech" in der Veranstaltung "Konzeptionelle Herausforderungen für die KI: Offenheit"

Der Workshop kombiniert Impulsvorträge mit interaktiven Diskussionen und bringt Perspektiven aus Ethik, Informatik und Sozialwissenschaften zusammen. Ziel ist es, gemeinsam Wege für eine verantwortungsvolle, faire und nachvollziehbare KI-Gestaltung zu skizzieren.

Speakerin auf dem media.think.tank.24 in der Medienstadt Potsdam Babelsberg

"Das wirkliche Potential von KI im Medienbereich"

mit anschließender Diskussion Sven Bliedung (Volucap) und Anna Hoffmann

auf der Fachtagung: KI IM AUDIOVISUELLEN PRODUCTION WORKFLOW – CREATIVE COLLABORATION VON DREHBUCH BIS DISTRIBUTION

Eine Initiative der Filmuniversität Babelsberg KONRAD WOLF und des Erich Pommer Instituts am 7. Juni 2024

Gibt es eine "Allgemeine Künstliche Intelligenz", die den Menschen übertrifft? - Ein klares Nein!

KI-Symbolbild via Adobe Firefly

KI wird zu oft wie ein menschliches Wesen behandelt, wie eine Entität: KI „denkt“, „versteht“, „berät“ - angeblich. KI kann all das nicht, denn KI ist kein Wesen mit Bewusstsein und echter Intelligenz, das eine gezielte kognitive Absicht verfolgen und eine eigenständige Erkenntnis haben kann. KI-Systeme können eigenständig keinen Sinn erzeugen und KI hat auch keinen Verstand. KI plant nicht, KI handelt nicht vorausschauend und KI nimmt uns auch nicht das strategische Denken ab, so gerne wir das vielleicht auch hätten. Das, was wir im Moment unter KI verstehen, sind hochkomplexe Systeme mit vielschichtigen Interaktionen, deren innere Zyklen so schnell geworden sind, dass sie von außen nicht mehr gut nachzuvollziehen sind.

Und weil wir durch die Geschwindigkeit und den hohen Interaktionsgrad nicht mehr alles im Inneren des Systems verstehen (die berüchtigte Black Box), werden jetzt für den Output dieser Systeme alle möglichen Zuschreibungen gemacht, die weder transparent hergeleitet werden können noch logisch ausreichend ableitbar sind.

Wir schreiben diesen Maschinen die Befähigung zum sinnvollen Handeln zu, bezeichnen sie als intelligente Agenten, doch das ist gefährlich, weil Intelligenz eine Eigenschaft des Menschen ist, die nicht von einem blinden technischen System kopiert werden kann, ganz gleich, wie viele Schnittstellen oder Informationen es hat.

"Gefahren, Chancen und Herausforderungen bei der Nutzung von KI"

Keynote auf dem "kommune.digital.forum" am 19.3.2025 "KI in der Verwaltung: So gestalten Sie eine erfolgreiche Bürgerkommunikation"

KI-Symbolbild via Adobe Firefly

"Wer generative KI verwendet, rezipiert Informationen auf Basis spezifischer Wertvorstellungen anderer, ohne diese in der Regel bewusst zu reflektieren. Diese Tatsache öffnet den Raum für Täuschung und Manipulation unter dem Deckmantel einer scheinbar überlegenen und vermeintlich neutralen, objektiven Technologie. Damit aber werden die Grundfesten unserer Weltwahrnehmung und unserer sinneserfahrungsbasierten Urteilskraft nachhaltig erschüttert. Text und Bild verlieren schließlich ihre Beweiskraft."

"Generative KI - jenseits von Euphorie und einfachen Lösungen",

Judith Simon | Indra Spiecker gen. Döhmann | Ulrike von Luxburg; Diskussion Nr. 34

Herausgegeben von der Nationalen Akademie der Wissenschaften Leopoldina (2024)

Wer die KI und ML zugrundeliegenden Techniken nicht verstanden hat, kennt die maschinellen Grundlagen für die Gegenwart und Zukunft nicht und trifft leicht Entscheidungen auf der Basis von (falschen) Erwartungen und Halbwissen. KI bietet viele Chancen, hat aber mehr Grenzen als oft vermutet und: sie ist nicht intelligent. Ich habe mich seit vielen Jahren mit dem Thema intensiv beschäftigt und durchleuchte gerne mit Ihnen den Hype und seine Risiken.

Viele Menschen schließen durch das, was sie sehen oder erleben, auf die Wirkungsweise von KI-Systemen. Das kann sehr irreführend sein, denn KI funktioniert nicht wie klassische Software oder bekannte regelbasierte Systeme. Der Begriff KI umfasst eine sehr unterschiedliche Gruppe von Algorithmusbasierten Verarbeitungsprozessen, die in ihrer Wirkungsweise sehr unterschiedlich sein können und zu seinem großen Teil auf statistischer Wahrscheinlichkeit statt auf mathematischer Genauigkeit oder logischer Herleitung beruhen.

KI-Funktionalitäten benötigen häufig keine extra Rollouts, sondern werden sukzessive in bestehende Anwendungen integriert. Darum ist vielen nicht klar, dass sehr viele Cloud- und Consumerdienste schon längst über KI/ML- Modelle laufen und KI ein ständiger Begleiter ist, wie etwa in den Empfehlungssystemen von Netflix und Amazon.

Generativer AI werden zur Zeit Fähigkeiten zugeordnet, die aus den erlebten Effekten seit 2023 hochgerechnet werden. Das ist ein schwieriges Denkmodell, denn KI hat andere Grenzen als IT.

KI-Symbolbild via Adobe Firefly

Workshop auf der re:publica 23 in Berlin

„AI for the planet instead of for cash“

Aufbauend auf Inputs aus den Best Practices der Ellen MacArthur Foundation zu den Möglichkeiten von KI für die Kreislaufwirtschaft entwickeln die Teilnehmenden Lösungsideen im Rapid-Prototypingverfahren (unter Einsatz von LEGO® SERIOUS PLAY®), die nach und nach zu einem Business-Ökosystem vernetzt werden.

„Neue Werkzeuge wie künstliche Intelligenz können dafür sorgen, dass die einzigen Grenzen, die wir erfahren, die unserer Vorstellungskraft und der Endlichkeit der Ressourcen der Welt sind.“ Ellen McArthur Stiftung

Carl Friedrich von Weizsäcker-Kolloquium vom 20. Juli 2022:

"KI-Kontextanalysen als notwendiges Entscheidungswerkzeug für Machine Learning"

Anna Hoffmann

KI-Kontextanalyse als KI-Entwicklungwerkzeug

KI-Business‐Designs durchleuchten, bevor viel Geld in die Hand genommen wird

Prozessberatung für die Frühphase von KI-Entwicklungen

"Erst die Betrachtung des individuellen Anwendungskontextes und der individuellen Einsatzumgebung erlauben eine umfassende Bewertung der mit dem Gebrauch von Algorithmen und KI-Systemen einhergehenden Kritikalität.“

Drucksache 19/23700 (bundestag.de), S. 66

Der Fragenkatalog der KI‐Kontextanalyse ermöglicht es, Machine Learning basierte KI‐Systeme schon ab dem ersten Entwurf des Use‐Cases auf die gestaffelten Kriterien eines menschenzentrierten und verantwortungsvollen KI-Business‐Designs hin zu durchleuchten und Optimierungsbedarf aufzuzeigen, bevor viel Geld in die Hand genommen wurde.

Die KI‐Kontextanalyse nimmt den geplanten spezifischen Anwendungskontext sowie die spätere Nutzerumgebung vertieft in den Blick. Dadurch gelingt eine differenzierte Analyse, die offene Fragen beantwortet, Chancen und Möglichkeiten der geplanten KI aufzeigt und praktische Risiken im Vorfeld sichtbar und lösbarer macht.

Kosten:

Die partizipative Analyse kann zu einem Honorarsatz von 150,00 € pro Stunde gebucht werden. Relevante Ergebnisse werden in der Regel ab vier Stunden gemeinsamer Arbeit erzielt.

KI-Symbolbild via Adobe Firefly

UIG-Tagung 23: "Fokus Mensch - Digitalisierung nachhaltig gestalten", 14.9.2023 in Karlsruhe: Talk und Workshop "Design für KI-Basierte Circular Economy"

Ein interdisziplinärer Co:Design Workshop mit haptischer Szenariomodellierung für neue, Machine Learning-basierten Lösungen für die Kreislaufwirtschaft und Closed Loops auf Basis einer Studie der Ellen McArthur Stiftung. KI kann, richtig eingesetzt, ein enorm leistungsfähiges Werkzeug sein:

Wie kann der Übergang zur Kreislaufwirtschaft durch den Einsatz von Machine Learning beschleunigt werden?

Welche Möglichkeiten ergeben sich durch den Einsatz von KI-Systemen für positive Veränderungen in einem größeren Maßstab?

Suchen Sie das Komplizierte!

"Nie war die Welt unübersichtlicher als heute - und vor allem komplizierter. Das Interessante ist allerdings: Zwar haben Menschen eine Sehnsucht nach dem Einfachen. Aber wir trainieren sie auch dazu.

Wenn man Menschen hingegen einen komplizierten Sachverhalt auch als kompliziert schildert, suchen sie sich anschließend tatsächlich nicht die verkürzend-verfälschende Erklärung aus, sondern gerade komplizierte Erklärungen.

So werden wir weniger empfänglich für die verlockende, aber falsche Variante. Eine Fähigkeit, die man in Zeiten von allverfügbaren Informationen nicht hoch genug schätzen kann."

Neurowissenschaftler Henning Beck, in "Suchen Sie das Komplizierte!", ManagerSeminare 11/24

Gibt es eine "Allgemeine Künstliche Intelligenz", die den Menschen übertrifft? - Ein klares Nein!

KI-Symbolbild via Adobe Firefly

KI wird zu oft wie ein menschliches Wesen behandelt, wie eine Entität: KI „denkt“, „versteht“, „berät“ - angeblich. KI kann all das nicht, denn KI ist kein Wesen mit Bewusstsein und echter Intelligenz, das eine gezielte kognitive Absicht verfolgen und eine eigenständige Erkenntnis haben kann. KI-Systeme können eigenständig keinen Sinn erzeugen und KI hat auch keinen Verstand. KI plant nicht, KI handelt nicht vorausschauend und KI nimmt uns auch nicht das strategische Denken ab, so gerne wir das vielleicht auch hätten. Das, was wir im Moment unter KI verstehen, sind hochkomplexe Systeme mit vielschichtigen Interaktionen, deren innere Zyklen so schnell geworden sind, dass sie von außen nicht mehr gut nachzuvollziehen sind.

Und weil wir durch die Geschwindigkeit und den hohen Interaktionsgrad nicht mehr alles im Inneren des Systems verstehen (die berüchtigte Black Box), werden jetzt für den Output dieser Systeme alle möglichen Zuschreibungen gemacht, die weder transparent hergeleitet werden können noch logisch ausreichend ableitbar sind.

Wir schreiben diesen Maschinen die Befähigung zum sinnvollen Handeln zu, bezeichnen sie als intelligente Agenten, doch das ist gefährlich, weil Intelligenz eine Eigenschaft des Menschen ist, die nicht von einem blinden technischen System kopiert werden kann, ganz gleich, wie viele Schnittstellen oder Informationen es hat.

Eine Information oder die Eingabe über einen Sensor bildet keine ausreichende Grundlage zur Erkenntnis von Zusammenhängen. Für echte Erkenntnisse braucht es echte Intelligenz, einen geschulten Geist, der durch viel Nachdenken, Bilden von Thesen, Prüfen und Verwerfen von Schlussfolgerungen trainiert ist. Es benötigt die Reflexion über Richtig oder Falsch und die Bereitschaft, eigene Denkfehler erkennen zu und das eigene Denken danach neu ausrichten zu können. All das können KI-Systeme nicht, auch nicht durch Reinforcement Learning und den Zugriff auf alle Halbwahrheiten des Internets.

Generative KI zeigt die Merkmale eines chaotischen Systems, denn die Ausgaben der fortgeschrittenen GenAI-Systeme sind nicht mehr vorhersehbar, sondern beliebig. Das sind wir von Computern nicht gewohnt. Computer lösen Aufgaben binär (mit 0 und 1), also kommt immer ein klares Ergebnis heraus. Zuverlässig, wiederholbar, überprüfbar.

Genau das sind Gen-AI Modelle wie die von OpenAI nicht: zuverlässige Maschinen.

Wenn derselbe Prompt, also die gleiche Anfrage, erneut an das System gestellt wird, kommt eine andere Antwort, oder gar eine „Halluzination“, ein völlig falsches Ergebnis. Halluzinationen sind kein Fehler im KI-System, sondern die natürliche Folge eines chaotischen Systems, dass nur auf der Basis von Mustern und Wahrscheinlichkeiten operiert, ohne die Befähigung zur eigenständigen Erzeugung von Sinn und Absicht, ohne die für sinnvolle Lösungen notwendige Umfeldintelligenz. Die Antworten von Gen-AI Modellen sind beliebig, und wenn das dann zufälliger Weise überraschend intelligent wirkt, das ist das nur ein Zufall, und kein Hinweis auf echte Intelligenz.

Umfeldintelligenz wird auch nicht durch Multimodale LLMs kommen:

Nur, weil zur Eingabe jetzt auch Bilder und Videos eingesetzt werden können, erzeugen die semantischen Assoziationen in den großen Sprachmodellen nicht auf einmal echte Erkenntnisse. Neuronale Netze sind durch die Bemühungen zum autonomen Fahren schon lange auf das Erkennen von Mustern in den Ihnen präsentierten kleinen Bildkacheln der abfotografierten Wirklichkeit getrimmt. Diese erkannten Muster können jetzt durch Text beschrieben werden – das ist nur eine Umkehr der Labelingfunktion. Das, was als Beschreibung der Welt durch das Labeln von Daten in die Neuronale Netzen einprogrammiert wurde, kommt jetzt als textliche Bildzuordnung wieder aus den NNs heraus.

KI-Symbolbild via Adobe Firefly

Nur weil wir semantische Zusammenhänge in schöner Sprache ausgedrückt als Output der KI erleben, denkt die Maschine nicht.

Die Ausgabe entspricht der auf visuelle Mustererkennung getrimmten Programmierung. Statt Zahlen oder Code erhalten wir ein Berechnungsergebnis in rhetorisch geschliffenen Worten, die auch nach Mustern blind zusammengesetzt, und nicht bewusst gewählt worden sind. Obwohl Sprache eine Grundform des Denkens darstellt (neben Bildern und Strukturen), gilt nicht der Umkehrschluss – die Nutzung von Sprachelementen ist kein Anzeichen dafür, dass die Maschine oder das KI-System denken kann oder sich intelligent verhält. Das Einspeisen von Videos und Bildern in Multimodale LLMs ist nur eine neue Form der maschinellen Verarbeitung. Es stellt keine bewusste Erweiterung des Umfeldwissens oder gar einen ersten Schritt zu echter Umfeldintelligenz dar.

KI-Symbolbild via Adobe Firefly

Neuronale Netze sind nur rudimentär in ihrem strukturellen Aufbau der Funktionsweise der Gehirnzellen nachempfunden. Nervenzellen dienen als Inspiration für die IT-Systemarchitektur. Die KI-Form der Neuronale Netze nutzt die Struktur von Nervenzellen als Bionik-Prinzip, die Entwickler schauen sich also aus der Natur etwas ab.

Durch dieses Abschauen von Effekten wird aber das zugrundliegende Objekt nicht verändert: Nur weil eine Oberfläche den „Lotuseffekt“ hat, also Wasser besser abperlt, wird das Objekt unter der Oberfläche nicht auf einmal zu einer Lotusblüte. So wird auch ein KI-System, das in der Softwarearchitektur auf dem Bionik-Prinzip der menschlichen Nervenzellen aufbaut, auch nicht plötzlich zu einem menschlichen Gehirn und verfügt über dessen Funktionsweisen und Outputs.

KI-Symbolbild via Adobe Firefly

Das Prinzip der Bionik wird auch bei den intelligenten Agenten eingesetzt, das Coding ist dem Prinzip des semantischen Tiefenlernens beim Menschen nachempfunden.

Damit ist die menschliche Fähigkeit zum Lernen über anknüpfende Assoziationen gemeint: Ich höre das Wort „Haus“ in einem neuen Kontext und verknüpfe für die Zukunft den neuen Begriff mit dem Wortfeld „Haus“. So kann der Begriff „Hausboot“ meinen Assoziationsraum für Wohnungen erweitern, und ich denke bei „Boot“ nicht nur an Fortbewegung, sondern auch an Aufenthaltsmöglichkeit. Genau auf diesem Verknüpfungsprinzip bauen die aktuellen GenAI-Modelle auf.

Modernen GenAI-Systeme, wie die von OpenAI, basieren auf dem Prinzip des Embeddings, das sich strukturell an das semantische Tiefenlernen beim Menschen anlehnt (Anwendung des Bionik Prinzips). Darum beherrschen GenAI Systeme Semantik auch besonders gut, aber eben nur das. GenAI Systeme können klug schwafeln, weil sie die rhetorische Grundlage dazu einprogrammiert bekommen haben. Mehr ist es nicht, auch bei den „Intelligenten Agenten“. Es macht keinen Unterschied für das Ergebnis, ob das zufällige Ergebnis nur auf einen Rutsch (wie bei Chat GPT oder durch mehrere Schritte (wie bei Modell 03) entsteht. Zuverlässiger wird das KI-System dadurch nicht.

Wenn Modell 03 besser programmieren kann, denn nicht, weil es auf einmal super logisch denken kann (das können leider auch manche Programmierer nicht), sondern weil Coding auf Programmiersprachen beruht, und Sprache und Semantikbeherrschung die wahre Befähigung der GenAI- Systeme ist.

Semantik ist ein mächtiges Werkzeug, doch es sollte uns nicht darüber hinwegtäuschen, das für echte Intelligenz sehr viel mehr nötig ist.

Das menschliche Gehirn und seine Fähigkeiten zur Erkenntnis aus Wahrnehmungen, zur Weitsicht, zu authentischen Empfindung, zu komplexen logischen Schlussfolgerung, zur Erfassung von dynamischen Umgebungsbedingungen und Ableitung von Schlüssen daraus können von keiner IT-Struktur wiedergegeben werden, auch nicht von solchen, die das Wort „Intelligenz“ als Begriffsbezeichnung in sich tragen, aber eben nicht „intelligent“ handeln können, weil sie keine eigenständigen Entitäten sind.

KI-Symbolbild via Adobe Firefly

KI kann, insbesondere durch die sinnvolle und zuverlässige Nutzung von Machine Learning, ein sehr nützliches Werkzeug sein, wenn die Grenzen dieser Technologie für den jeweiligen Anwendungskontext genau im Auge behalten werden. Bei dem Ausrufen von „Allgemeiner künstlicher Intelligenz“, die angeblich das systemische Denken, die weitsichtige Planung und das aktive Einbeziehen von dynamischen Umfeldbedingungen der menschlichen Intelligenz übertreffen soll, müssten die Alarmglocken laut schrillen. Nur weil etwas überzeugend verkauft wird, wird es nicht wahrer.

Anna Hoffmann 12. 1. 2025